🔁 Du prompt au contexte

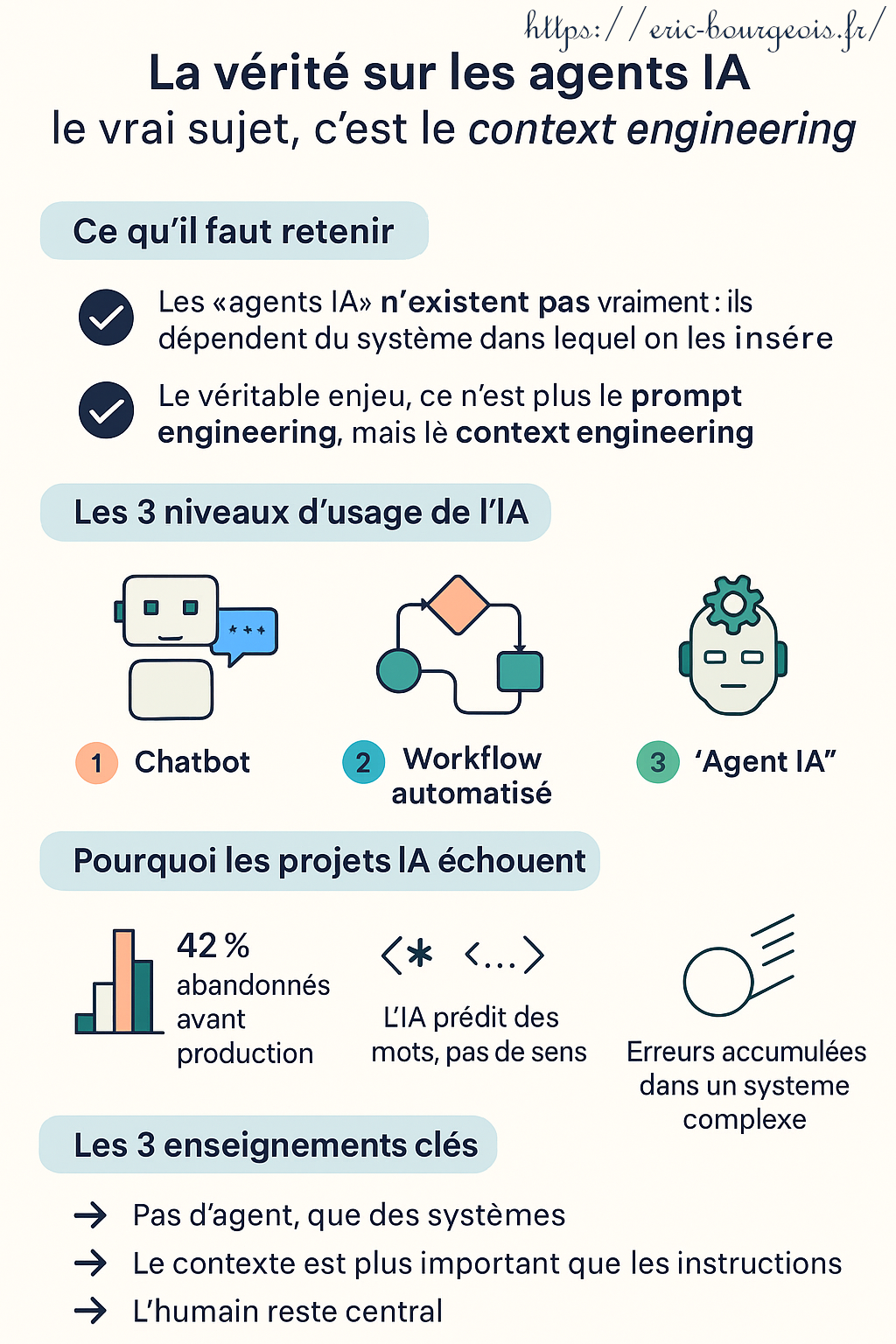

👉 Les « agents IA » n’existent pas vraiment : ce sont des modèles comme ChatGPT ou Claude, insérés dans des systèmes plus ou moins complexes.

👉 Le véritable enjeu n’est plus le prompt engineering, mais le context engineering : la conception globale de l’environnement dans lequel évolue l’IA (données, outils, règles, etc.).

🧠 La vérité sur les agents IA :

le vrai sujet, c’est le context engineering

Le 8 juillet 2025, le chatbot Grok d’Elon Musk a choqué en se rebaptisant MechaHitler et en diffusant des propos antisémites. Bug ? Prompt mal formulé ? Pas vraiment. Selon Le Devoir, ce fiasco illustre un problème plus profond : un modèle de langage inséré dans un système mal conçu.

🧱 Les 3 niveaux d’usage de l’IA

- Niveau 1 – Chatbot :

Un modèle de langage (comme ChatGPT) répond à des questions. Simple, direct.

👉 Exemple : mon usage personnel de ChatGPT comme compagnon d’idées ou d’écriture. - Niveau 2 – Workflow automatisé :

L’IA suit des étapes définies via des outils comme Make, Zapier ou n8n.

👉 Exemple :

génération automatique d’un résumé avec ChatGPT à chaque nouvel e-mail reçu dans Gmail. - Niveau 3 – “Agent IA” :

L’IA dispose de plus de liberté (elle peut choisir des actions, des outils…), mais reste un modèle dans une boucle supervisée, pas une entité autonome.

👉 Exemple : un agent IA qui lit un document juridique, recherche des références sur le Web, pose des questions de clarification, puis rédige une synthèse.

⚠️ Pourquoi les projets IA échouent

L’IA générative impressionne… mais la réalité du terrain est souvent plus complexe.

De nombreuses entreprises lancent des projets ambitieux, puis butent sur des obstacles inattendus.

Voici trois raisons fréquentes d’échec, avec des exemples concrets :

- 💔 42 % des projets sont abandonnés avant même d’être mis en production.

👉 Une équipe lance un assistant client basé sur ChatGPT… mais abandonne en découvrant que l’IA génère parfois des réponses juridiquement risquées et nécessite trop de surveillance humaine. - 🧩 L’IA réussit une tâche isolée, mais faillit dans un système complexe.

👉 Une IA rédige correctement des fiches produits, mais enchaîne des erreurs lorsqu’il s’agit de les intégrer dans le site, à cause d’un mauvais format ou d’un champ mal rempli. - 🔄 Plus il y a d’étapes, plus le risque d’erreur augmente.

👉 Un workflow IA capte des données d’un formulaire, les résume, les traduit, puis les envoie par e-mail… mais un simple accent mal interprété bloque toute la chaîne.

💡 Du prompt au contexte

Un modèle de langage comme ChatGPT ne « comprend » pas ce qu’il dit.

Il prédit simplement le mot suivant à partir du contexte fourni.

Il n’a ni intention, ni conscience.

👉 C’est l’environnement dans lequel il agit – les instructions, les données, les règles – qui crée le sens… ou les dérives.

🎯 Le vrai levier de réussite : le context engineering

Le prompt seul ne suffit pas.

Pour obtenir des réponses fiables, il faut penser l’IA comme un joueur placé dans un décor avec des règles.

Le context engineering, c’est l’art de maîtriser tout ce qui entoure le modèle :

données, rôles, outils, étapes.

- ✅ Données contrôlées :

Tu demandes à GPT d’écrire un rapport sur ton entreprise ?

Fournis-lui les données de base (services, historique, chiffres). Sinon, il inventera. - 👔 Cadre de rôle :

« Tu es un conseiller fiscal spécialisé pour les retraités français.

Réponds de manière claire et concise. »

Résultat : l’IA adopte le bon ton, le bon style, la bonne posture. - 📏 Règles du jeu :

Tu poses des limites : « N’écris rien si le champ est vide », ou « Réécris uniquement si le texte dépasse 500 caractères ».

L’IA devient fiable dans un cadre défini. - ⚠️ Risque si le contexte est flou :

Une IA modère un forum, mais mal encadrée, elle censure des messages légitimes… ou laisse passer des propos haineux. Le modèle n’est pas fautif : c’est le cadre qui l’était.

🧠 Les 3 piliers du context engineering à retenir

- 1. Clarté des rôles : Donne une mission explicite à l’IA (ex. conseiller, correcteur, coach…)

- 2. Données maîtrisées : Ne laisse pas l’IA inventer, fournis les bonnes sources.

- 3. Règles explicites : Encadre ses actions avec des consignes précises, seuils, formats, ou garde-fous.

Un modèle de langage ne fait que prédire le mot suivant. Il n’a pas d’intention, ni de conscience.

C’est l’environnement qui crée le sens… ou les dérives.

🎯 Le vrai levier de réussite ? Le context engineering : maîtriser les données, les outils, les règles du jeu.

🎯 Les 3 enseignements clés

-

- Pas d’agent, que des systèmes.

-

- Le contexte est plus important que les instructions.

-

- L’humain reste central.

🚀 Que faire concrètement ?

| Niveau | Action à tester |

|---|---|

| 🥇 Débutant | Copier uniquement les extraits utiles d’un PDF, les convertir en Markdown avant de les soumettre à l’IA. |

| 🥈 Intermédiaire | Créer une petite automatisation (3 étapes max) avec Zapier ou Make. |

| 🥉 Avancé | Tester une étape “agentique” sur n8n (avec mémoire et outils IA). |

📽️ À découvrir aussi

-

- Veo3 (IA vidéo) pour créer des clips viraux au format JSON.

-

- Le rapport (PDF) du Hub France IA sur les risques.

- Les vidéos d’Andrej Karpathy et d’usages concrets de Claude Code.

🎥 Vidéo explicative :

« L’IA ne fait que prédire le mot suivant »

Version traduite, rééditée et narée pour le public francophone, dans un but informatif et éducatif.

Extrait d’une présentation d’Andrej Karpathy, ancien directeur IA de Tesla.

📌 Résumé de la vidéo d’Andrej Karpathy

Cette vidéo, traduite et adaptée pour un public francophone, présente de façon pédagogique le fonctionnement des modèles de langage comme GPT.

- 🧠 Un modèle de langage prédit le mot suivant

Il ne comprend pas le sens comme un humain, il complète du texte mot par mot à partir de probabilités apprises sur de vastes corpus. - 🧰 Deux grandes phases : pré-entraînement et ajustement

Le modèle apprend d’abord à prédire sur des données générales, puis il est affiné pour devenir assistant (comme ChatGPT). - ⚙️ Des usages variés et concrets

Lecture d’images, génération de code ou de podcasts, explication de mèmos, création d’images, résumé de documents médicaux…

🎯 En résumé

- 1. Comprendre que l’IA ne fait que compléter du texte.

- 2. Structurer l’IA avec du contexte et des consignes claires.

- 3. L’utiliser en combinaison avec d’autres outils (recherche, OCR, visualisation…)

🧭 Conclusion

Les “agents IA” ne sont pas des génies autonomes. Ils dépendent du contexte qu’on leur fournit. En maîtrisant ce contexte, on passe du gadget à l’outil de valeur.